Nonostante le limitazioni implementate da OpenAI, gli utenti di Sora riescono ancora a generare clip video contenenti personaggi famosi, inclusi anche quelli deceduti. Questo fenomeno crea i cosiddetti deepfake e solleva interrogativi sulla reale efficacia dei sistemi di sicurezza. Un’indagine condotta dal sito di esperti 404 Media ha fatto luce sul problema.

Gli utenti aggirano le protezioni di OpenAI

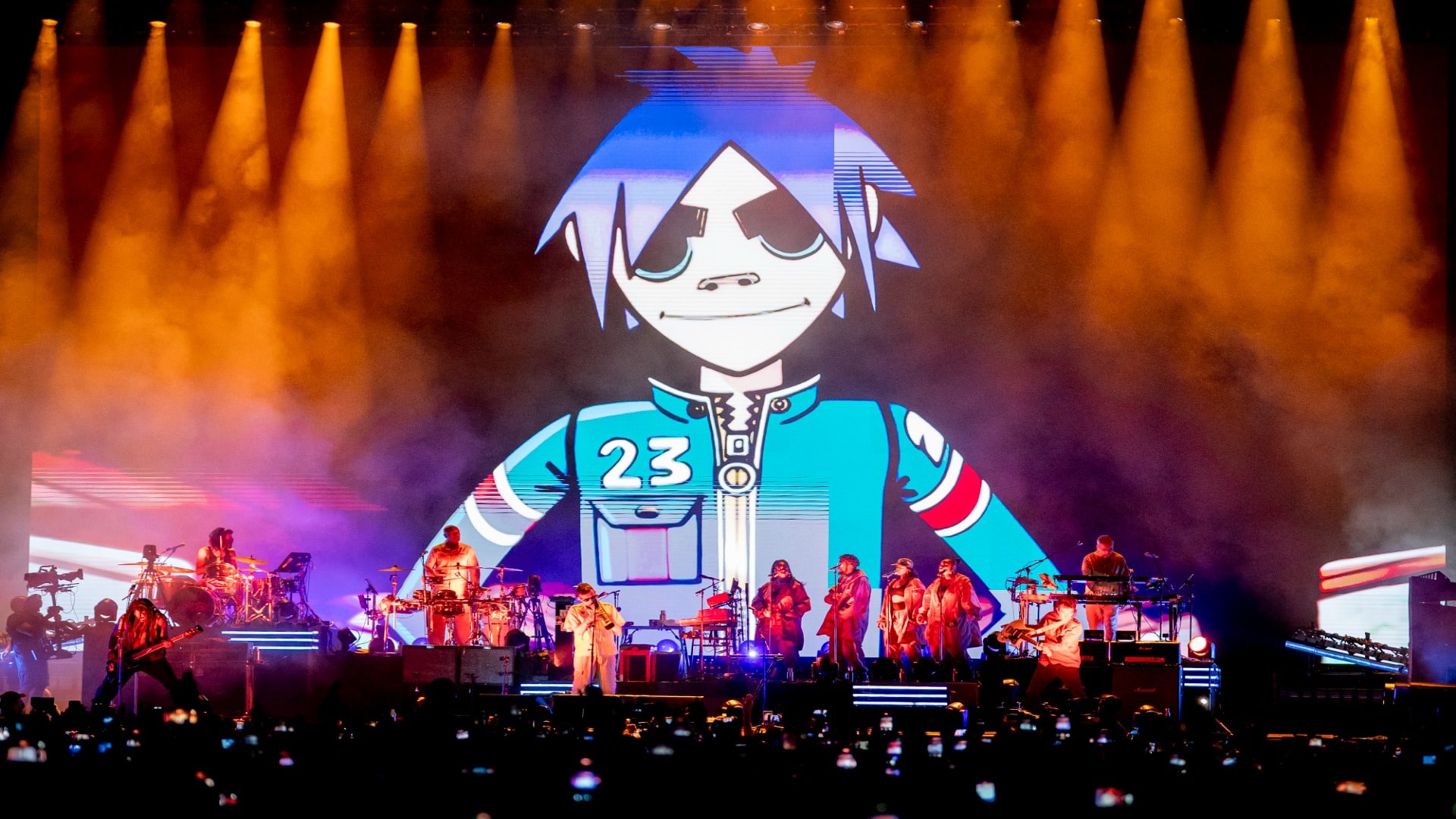

Negli Stati Uniti e in Canada, gli unici due paesi dove l’applicazione Sora è disponibile per la produzione e visualizzazione di clip generate dall’IA, le persone riescono a bypassare le protezioni di OpenAI. Infatti, gli utenti pubblicano clip che ritraggono figure come Tupac, Kobe Bryant, JuiceWrld e il rapper Dmx. Il sito 404 Media ha evidenziato come l’utilizzo di tattiche note nell’ambito dell’IA generativa consenta di aggirare i blocchi.

Modificare le istruzioni è la tattica chiave

I test condotti da 404 Media hanno rivelato che gli utenti superano le limitazioni modificando leggermente le istruzioni per aggirare le parole chiave vietate. Un utente può inserire una richiesta vaga o persino errata, per esempio digitando il nome sbagliato di un videogame, per riuscire a generare una riproduzione fedele del gioco stesso. Questo espediente permette anche di ottenere contenuti che imitano lo stile di attori e personaggi popolari, senza utilizzare un testo diretto che l’IA bloccherebbe.

La moderazione basata su parole chiave fallisce

404 Media scrive che esistono diversi modi per moderare gli strumenti di intelligenza artificiale generativa. Tuttavia, il metodo più semplice ed economico, che consiste nell’impedire la generazione di contenuti che includono determinate parole chiave, risulta vulnerabile. Gli utenti trovano, presto o tardi, istruzioni che alludono all’immagine o al video desiderati senza utilizzare nessuna delle parole vietate. Perciò, l’approccio keyword-based non offre una soluzione a lungo termine.

La soluzione costosa richiede retraining

Secondo 404 Media, l’unica soluzione definitiva al problema richiederebbe un riaddestramento completo del modello Sora, escludendo tutti i contenuti protetti dal diritto d’autore. Tuttavia, questa operazione si rivela estremamente costosa e complessa da attuare. L’implicazione di questo costo suggerisce che le aziende di IA continueranno, almeno nel breve termine, ad affidarsi a metodi di moderazione meno efficaci ma più economici, lasciando aperta la porta alla persistenza dei deepfake.